De AI Act vanuit een compliance-perspectief: verantwoord AI-gebruik binnen organisaties

AI speelt een steeds grotere rol in ons leven. Compliance officer Sherwien Ramsoedh ziet zowel kansen als risico’s: "AI biedt innovatieve mogelijkheden, maar is niet onfeilbaar. Menselijke controle blijft noodzakelijk vanwege eerdere incidenten en de bijbehorende risico’s. Voor veel mensen is AI een ‘black box’, vooral als het gaat om hoe beslissingen worden genomen of hoe de technologie precies werkt. Toch hebben deze toepassingen de kracht om je leven te beïnvloeden, direct of indirect." Om hier grip op te houden, heeft de EU-wetgever een raamwerk van regels opgesteld, waarvan de AI Act een belangrijk onderdeel is. Sinds 2 februari 2025 is een deel van deze verordening van toepassing.

In dit artikel bespreekt Sherwien de AI Act en de recente ontwikkelingen, zoals het intrekken van het wetsvoorstel voor AI-aansprakelijkheid (AILD) en de nieuwe richtlijnen over verboden AI-praktijken. Ook lees je hoe jouw organisatie zich kan voorbereiden met een handig stappenplan.

Een raamwerk van regelgeving

"Voordat we inzoomen op de AI Act, is het belangrijk om het bredere kader te schetsen," zegt Sherwien. "De AI Act maakt deel uit van het EU-regelgevingsraamwerk voor AI, samen met de vernieuwde Productaansprakelijkheidsrichtlijn (PLD). Hoewel er ook een voorstel was voor een aparte AI Aansprakelijkheidsrichtlijn (AILD), is dat inmiddels ingetrokken."

Toch blijven de AI Act en de PLD de belangrijkste pijlers voor veilig en verantwoord AI-gebruik in de EU. Vooral de AI Act speelt hierin een grote rol, omdat de PLD een breder toepassingsgebied heeft dan alleen AI.

Wat is de inhoud van de AI Act?

De AI Act is een Europese wet die het gebruik van AI reguleert en bepaalde praktijken verbiedt, zoals sociale scoring en biometrische surveillance in openbare ruimtes. “De verordening is risico-gebaseerd ingestoken”, legt Sherwien uit. “De verplichtingen hangen af van het risiconiveau van AI-systemen, dat wordt bepaald door de impact op veiligheid en fundamentele rechten en vrijheden.”

Organisaties moeten beoordelen of hun AI-systemen een hoog risico vormen voor deze rechten, door in bepaalde situaties een grondrechteneffectenbeoordeling (FRIA) uit te voeren. Deze beoordeling maakt deel uit van het risicobeheersingsproces binnen de organisatie.

De AI Act kent vier risiconiveaus voor AI (zie onderstaande tabel).

| Verboden AI-praktijken | Hoog risico AI-systemen | Gelimiteerde risico AI-systemen | Laag risico AI-systemen |

|

Social scoring. Biometrische categorisering. Emotieherkenning op de werkplek. Manipulatieve AI-systemen. |

Systemen met een hoog risico, die een significante impact kunnen hebben op grondrechten, zoals juridische en overheidsbeslissingen (AI-systemen die bewijsmateriaal beoordelen of asielaanvragen verwerken). |

Generatieve AI-systemen, zoals Copilot en ChatGPT. Chatbots en AI-systemen voor algemeen gebruik.

|

Spamfilters. Aanbevelingssystemen zoals AI-algoritmes die muziek of films aanbevelen op Netflix of Spotify. Chatbots en virtuele assistenten. |

Een grensoverschrijdende wetgeving

De AI-verordening is de eerste uitgebreide set regels voor kunstmatige intelligentie ter wereld. Sherwien: “In die zin is de AI Act uniek. Het is een specifieke EU-wetgeving die niet alleen binnen de interne markt geldt, maar ook extraterritoriaal van toepassing is.”

Extraterritoriaal houdt in dat de wet niet alleen Europese bedrijven raakt, maar ook partijen buiten de EU—zoals Amerikaanse en Chinese tech-bedrijven—die AI-gedreven producten op de Europese markt willen brengen. Zij moeten zich eveneens aan deze regelgeving houden.

Niet-naleving kan leiden tot forse boetes, afhankelijk van de ernst van de overtreding:

- Zware schendingen: Tot 35 miljoen euro of 7% van de wereldwijde jaaromzet, met mogelijke strafrechtelijke gevolgen.

- Schendingen bij hoog-risico AI: Tot 15 miljoen euro of 3% van de wereldwijde jaaromzet.

- Kleinere overtredingen: Tot 7,5 miljoen euro of 1% van de wereldwijde jaaromzet.

De AI Act legt daarmee aanzienlijke financiële sancties op om naleving te waarborgen.

Verplichtingen aan de keten

De AI Act kent rechten toe en legt verplichtingen op aan leveranciers, importeurs, vertegenwoordigers, distributeurs, gebruikers van en getroffenen door AI. “Dat geldt voor de hele AI-waardeketen”, legt Sherwien uit.

Transparantieverplichtingen

De AI Act schrijft transparantieverplichtingen voor aan ontwikkelaars en aanbieders van AI-systemen, zodat gebruikers weten dat ze met een AI-oplossing werken. En hoe deze zijn antwoorden genereert en welke risico's eraan verbonden zijn.

Sherwien verduidelijkt: “Op die manier wil de EU af van het ‘black box’-gevoel dat AI-systemen vaak oproepen—het idee dat beslissingen worden genomen zonder dat gebruikers begrijpen hoe of waarom. Voor systemen die directe interactie hebben met mensen, zoals de generatieve chatbots zoals Copilot, ChatGPT of Gemini, geldt dat deze de gebruiker moeten informeren dat ze gebruikmaken van AI en dat de antwoorden gegenereerd zijn.”

AI-geletterdheid

De AI act heeft AI-geletterdheid (AIG) als verplichting voor organisaties geïntroduceerd, zodat medewerkers voldoende kennis hebben over de technische, ethische en juridische aspecten van AI.

Ze moeten weten wat de risico’s zijn en hoe ze AI effectief en verantwoord kunnen toepassen. “Denk aan een medewerker die vertrouwelijke klantinformatie in een AI-tool wil invoeren maar zich bedenkt, omdat hij weet welke risico’s eraan hangen”, zegt Sherwien.

AIG gaat zowel over doelgroepgerichte kennis over AI en wat het is, maar ook over het (juiste) gebruik van de tools en toepassingen.

“Je moet maatregelen treffen om AI-geletterdheid te implementeren in je organisatie”, legt Sherwien uit. Welke maatregelen dat zijn, schrijft de AI Act niet voor.

Volgens Sherwien moet je denken aan het maken of inkopen van cursussen en trainingen en het opnemen van AI-geletterdheid in je beleid. “Het is een meerjarenaanpak. Je kunt niet van nul naar honderd gaan, en daarnaast kun je jezelf met één cursus ook niet meteen AI-geletterd noemen.”

Organisaties kunnen AI-geletterdheid bevorderen door:

- richtlijnen op te stellen voor AI-gebruik;

- regelmatig het gebruik van AI te monitoren;

- de cursusinhoud op basis van de evaluatie ervan aan te passen.

Sherwien geeft een tip: "De Autoriteit Persoonsgegevens heeft voor die meerjarenaanpak een handreiking gepubliceerd, zeer waardevol en handig."

Sherwien, waarom is het zo belangrijk dat deze wet in werking is getreden?

“In de eerste plaats helpt de wet bedrijven AI op een ethische en verantwoorde manier in te zetten. De snelle ontwikkeling van AI brengt aanzienlijke risico's met zich mee, zoals misbruik van grondrechten en bedreigingen voor de veiligheid van burgers. Nu is het echt noodzakelijk om hier meer aandacht voor te hebben.

De risico-gebaseerde aanpak biedt bedrijven de mogelijkheid om AI gecontroleerd te gebruiken, zonder onnodige beperkingen. De wet maakt het mogelijk risico’s beter te beheersen en tegelijkertijd innovatie te ondersteunen.

Daarnaast zijn de financiële gevolgen, zoals hoge boetes, een belangrijke drijfveer voor naleving van de wet. Bedrijven die zich aan de wet houden, verminderen hun juridische risico's en verbeteren hun betrouwbaarheid en reputatie.

Kortom, de AI-verordening helpt risico's zoals hallucinaties in resultaten en vooroordelen door niet-representatieve trainingsdata beter te beheersen. Dit verhoogt de betrouwbaarheid van AI-systemen en helpt bedrijven om vertrouwen te winnen bij klanten en stakeholders."

Wat zijn jouw verwachtingen rond de AI Act?

“Ik ben nog steeds positief gestemd over de AI Act, omdat het een stap is richting verantwoord en ethisch AI-gebruik. Net als de AVG zal deze wetgeving wereldwijd invloed hebben.

De AI Act vraagt om actie binnen verschillende afdelingen, van directie tot HR, Juridische Zaken, Ict, Inkoop, Compliance en Security. Bijvoorbeeld bij inkoop: zorg dat je duidelijke afspraken maakt met AI-leveranciers, zodat de aansprakelijkheid ligt waar het hoort. De EU biedt modelcontracten met bepalingen die je kunt toepassen en aanpassen aan de specifieke behoeften van je organisatie. De AI Act biedt niet alleen bescherming tegen risico’s, maar ook de kans om je als verantwoord AI-leider te positioneren.”

En hoe zit het dan met de recente ontwikkelingen rondom de AI Liability Directive (AILD)?

"De AI Aansprakelijkheidsrichtlijn (AILD) was bedoeld om, samen met de PLD en de AI Act, een wettelijk kader voor AI in de EU te vormen. Maar volgens het Werkprogramma 2025 van de Europese Commissie is er no foreseeable agreement tussen de lidstaten. Daarom wordt de AILD ingetrokken.

Dit besluit lijkt deels beïnvloed door externe factoren, maar ook door een veranderde koers van de Europese Commissie. Het gevolg? Er komen voorlopig geen uniforme EU-regels voor AI-gerelateerde schade. In plaats daarvan blijven nationale regels gelden voor aansprakelijkheid bij schade door AI."

Is er een stappenplan waarmee organisaties aan de slag kunnen?

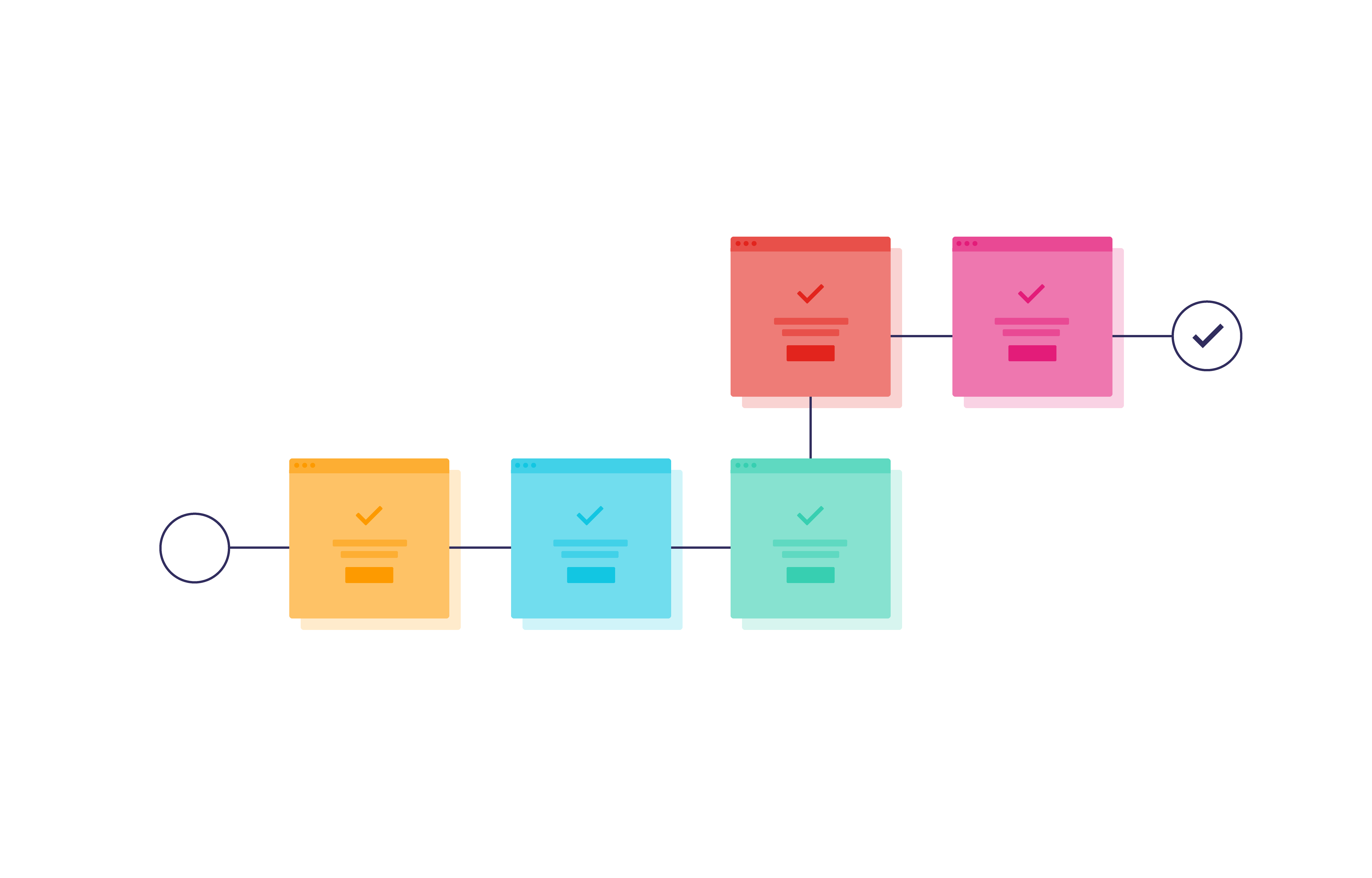

Sherwien heeft een handig stappenplan opgezet:

1. Verkrijg inzicht in gebruik

Inventariseer alle AI-systemen binnen de organisatie. "Waar zet je AI in? Wie gebruikt het en met welk doel? Dit inzicht helpt bepalen of je te maken hebt met hoog-risico-systemen of verboden AI-praktijken."

2. Stel een AI-beleid op

Ontwikkel een duidelijk AI-beleid met een visie, doelstellingen en richtlijnen voor inkoop, personele verplichtingen en eisen voor AI-producten. Leg ook je processen voor risico- en impactbeoordeling vast om transparantie te waarborgen. Sherwien: “Integreer dit beleid in bestaande structuren, zoals personeels-, privacy-, data- en informatiebeveiligingsbeleid. En vooral: communiceer erover met je doelgroep, verzamel feedback en zorg dat het beleid aansluit bij je organisatie.”

3. Voer risicobeoordelingen uit waar nodig

Evalueer al je AI-systemen, met extra aandacht voor hoog-risico toepassingen. Controleer of je geen verboden AI-praktijken hanteert en raadpleeg zowel de wet als de recente richtsnoeren van de Europese Commissie. Beoordeel transparantie, datakwaliteit, gebruikte datasets, veiligheid en de impact op gebruikers. “Bij impactvolle beslissingen op grondrechten is menselijke controle absoluut nodig.”

4. Ontwikkel en bevorder AI-geletterdheid

Train medewerkers die met AI werken in de technische, ethische en juridische aspecten. Ze hoeven geen diepgaande technische kennis te hebben, maar moeten AI wel begrijpen. Sherwien: “Je hoeft niet precies te weten hoe een LLM werkt, maar wel de basisprincipes.” (Tip: Gebruik de handreiking van de Autoriteit Persoonsgegevens om AI-geletterdheid te bevorderen.)

5. Leg een AI-register aan

Sherwien raadt elke organisatie aan om een AI-register bij te houden, ondanks dat het vanuit de AI Act niet verplicht is. “Het is een goede praktijk om alle AI-systemen in je organisatie te documenteren. Een bekende lijfspreuk van Sherwien is: “Overzicht leidt namelijk tot inzicht en van inzicht kom je tot uitzicht.”

In het register noteer je:

- Welk AI-systeem je gebruikt en wie de aanbieder is.

- Binnen welk classificatieniveau van de AI Act het systeem valt.

- Welke afdeling het gebruikt en met welk doel.

- Welke (contractuele) waarborgen er zijn met betrekking tot transparantieverplichtingen vanuit de aanbieder.

- Of er besluitvorming plaatsvindt met of zonder menselijke tussenkomst.

- Welke gegevens het systeem verwerkt.

Ondanks dat een AI-register niet hetzelfde is als een gegevensverwerkingsregister onder de AVG, kun je beide registers goed op elkaar afstemmen. Daardoor heb je een helder overzicht en betere controle over het AI-gebruik binnen je organisatie.

6. Stel een multidisciplinair team samen

Vorm een team voor AI-governance en ethiek met juridische experts, technische specialisten, product- en diensteigenaren, en privacy- en securityprofessionals. Dit team beoordeelt zowel de kansen als de risico’s van AI en sluit aan op je bestaande risicobeheersingsmethodiek. Sherwien: “Een gevarieerd team met diverse expertises voorkomt tunnelvisie en draagt bij aan verantwoord en veilig AI-gebruik.”

7. Zorg voor betrokkenheid van de directie

Betrek de directie en laat hen de beslissingen nemen. Het is belangrijk dat zij goed geïnformeerd zijn over zowel de risico’s als kansen van AI. Sherwien legt uit: “Het bestuur moet AI niet alleen zien als een kans om winst te maken, maar ook de risico’s begrijpen, zoals beveiligingslekken en bevooroordeelde en onjuiste uitkomsten. Een deskundig team dat hen ondersteunt met adviezen en risicobeoordelingen kan hierbij helpen. Wanneer het management de AI-aanpak steunt, vergroot dit de acceptatie binnen de organisatie.”

Sherwien sluit af: “De AI Act wordt steeds meer van toepassing, dus begin nu! Start klein, breid stapsgewijs uit en evalueer je aanpak. Maak gebruik van de gefaseerde invoering om je goed voor te bereiden. Door nu actie te ondernemen, zorg je voor verantwoord AI-gebruik en versterk je naleving, betrouwbaarheid en reputatie.”

AI Act: Een belangrijke stap in de richting van verantwoord en ethisch AI-gebruik

De AI Act is een baanbrekende wetgeving die een belangrijke stap zet richting verantwoord en ethisch gebruik van kunstmatige intelligentie. Het biedt organisaties de handvatten om AI op een transparante, gecontroleerde manier in te zetten, met aandacht voor de ethische, juridische en maatschappelijke implicaties. De wet legt niet alleen verplichtingen op, maar biedt bedrijven ook een kans om zich te positioneren als verantwoorde pioniers op het gebied van AI. Door goed voorbereid te zijn, kunnen organisaties niet alleen voldoen aan de wetgeving, maar ook hun betrouwbaarheid en reputatie versterken. Nu is het tijd om aan de slag te gaan en de voordelen van AI op een verantwoorde manier in te zetten!

Misschien vind je dit leuk

Anderen hebben deze artikelen gelezen

De AI Act: wat is er veranderd sinds augustus 2025?

“Als jouw AI iets doms doet, doet hij dat namens jou” | Leo Visser over het belang van goede datasets